هوش مصنوعی که در زمینه محتوای هوش مصنوعی آموزش دیده است، از بین می رود، آیا Threads یک رهبر ضرر برای داده های هوش مصنوعی است؟ – مجله کوین تلگراف

[ad_1]

به گزارش بیت ارز و به نقل از کوین تلگراف

ChatGPT آدمخوارها را می خورد

تبلیغات ChatGPT در حال کاهش است، با جستجوی Google برای “ChatGPT” 40٪ از اوج خود در آوریل، در حالی که ترافیک وب به وب سایت ChatGPT OpenAI در ماه گذشته تقریبا 10٪ کاهش یافته است.

این فقط قابل انتظار است – با این حال کاربران GPT-4 نیز گزارش می دهند که این مدل به طور قابل توجهی احمقانه تر (اما سریعتر) از قبل به نظر می رسد.

یک نظریه این است که OpenAI آن را به چندین مدل کوچکتر تقسیم کرده است که در مناطق خاصی آموزش دیده اند که می توانند پشت سر هم عمل کنند، اما نه کاملاً در یک سطح.

اما یک احتمال جذاب تر ممکن است همچنین نقشی را ایفا می کند: آدم خواری هوش مصنوعی.

وب در حال حاضر غرق شده است AI تولید شده است متن و تصاویر، و این دادههای مصنوعی به عنوان دادهای برای آموزش هوش مصنوعی حذف میشوند و باعث ایجاد یک حلقه بازخورد منفی میشوند. هرچه یک مدل دادههای هوش مصنوعی بیشتری دریافت کند، خروجی برای انسجام و کیفیت بدتر میشود. این کمی شبیه اتفاقی است که وقتی از یک فتوکپی کپی می کنید، اتفاق می افتد و تصویر به تدریج بدتر می شود.

در حالی که دادههای آموزشی رسمی GPT-4 در سپتامبر 2021 به پایان میرسد، به وضوح چیزهای بیشتری از آن میداند و OpenAI اخیراً آن را بسته است. وب گردی افزونه

مقاله جدیدی از دانشمندان دانشگاه رایس و استنفورد با یک مخفف زیبا برای این موضوع ارائه شده است: مدل اختلال اتوفاژی یا MAD

آنها گفتند: “نتیجه گیری اولیه ما در تمام سناریوها این است که بدون داده های واقعی تازه کافی در هر نسل از یک حلقه اتوفاگ، مدل های تولیدی آینده محکوم به کاهش تدریجی کیفیت (دقت) یا تنوع (یادآوری) آنها هستند.”

اساساً مدلها شروع به از دست دادن دادههای منحصربهفردتر اما کمتر نشاندهنده میکنند، و خروجیهای خود را روی دادههای کمتر متنوع در یک فرآیند مداوم سختتر میکنند. خبر خوب این است که این بدان معناست که اگر ما بتوانیم راهی برای شناسایی و اولویت بندی محتوای انسانی برای مدل ها پیدا کنیم، هوش مصنوعی اکنون دلیلی برای نگه داشتن انسان ها در جریان دارد. این یکی از برنامههای رئیس OpenAI سام آلتمن با پروژه بلاک چین اسکن کره چشم او، Worldcoin است.

آیا Threads فقط یک رهبر ضرر برای آموزش مدل های هوش مصنوعی است؟

شبیه سازی توییتر Threads حرکتی عجیب توسط مارک زاکربرگ است زیرا کاربران اینستاگرام را آدمخوار می کند. این پلتفرم اشتراکگذاری عکس تا 50 میلیارد دلار در سال درآمد دارد، اما حدود یک دهم آن را از Threads به دست میآورد، حتی در سناریوی غیرواقعی که 100 درصد سهم بازار را از توییتر میگیرد. Alex Valaitis از Big Brain Daily پیشبینی میکند که ظرف 12 ماه یا بسته میشود یا دوباره به اینستاگرام اضافه میشود، و استدلال میکند که دلیل واقعی راهاندازی آن در حال حاضر «داشتن محتوای متنی بیشتر برای آموزش مدلهای هوش مصنوعی متا بود».

ChatGPT بر روی حجم عظیمی از داده ها از توییتر آموزش داده شده است، اما ایلان ماسک برای جلوگیری از وقوع آن در آینده اقدامات نامطلوب مختلفی انجام داده است (هزینه برای دسترسی API، محدود کردن نرخ و غیره).

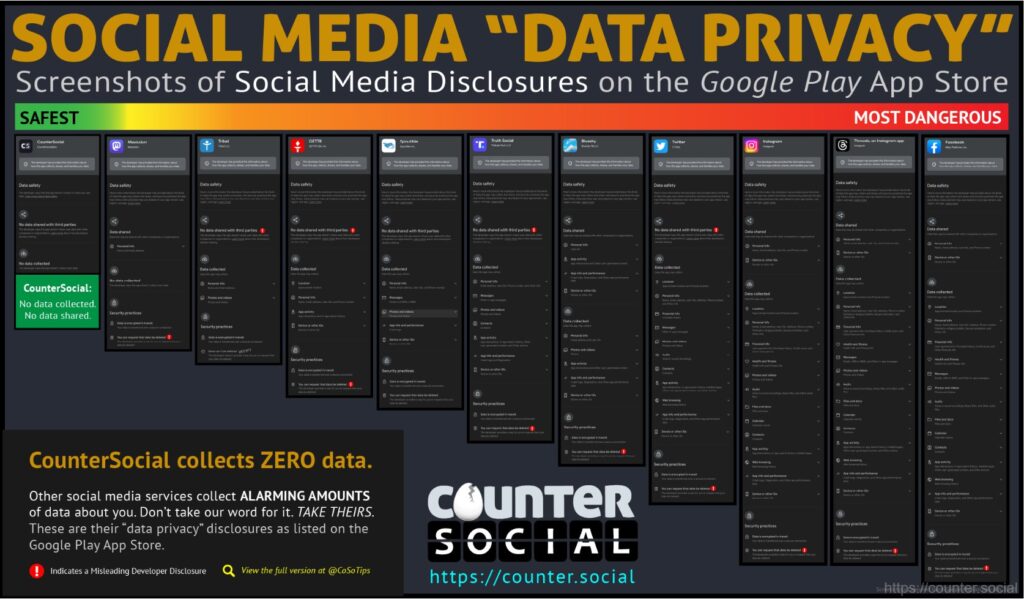

زاک در این زمینه به عنوان تشخیص تصویر متا فرم دارد نرم افزار هوش مصنوعی SEER بر روی یک آموزش دیده بود میلیارد عکس های ارسال شده در اینستاگرام کاربران در خطمشی رازداری با آن موافقت کردهاند و بیش از تعداد کمی از آنها موافقت کردهاند اشاره شد برنامه Threads داده ها را در مورد هر چیزی که ممکن است جمع آوری می کند، از داده های بهداشتی گرفته تا اعتقادات مذهبی و نژاد. این داده ها به ناچار برای آموزش مدل های هوش مصنوعی مانند LLaMA فیس بوک (مدل زبان بزرگ متا AI) استفاده خواهند شد.

در همین حال، ماسک به تازگی یک رقیب OpenAI به نام راه اندازی کرده است xAI که داده های توییتر را برای LLM خود استخراج می کند.

چت ربات های مذهبی بنیادگرا هستند

چه کسی حدس می زد که آموزش هوش مصنوعی بر روی متون مذهبی و صحبت کردن با صدای خدا ایده وحشتناکی باشد؟ در هند، چت رباتهای هندو که خود را به عنوان کریشنا در میآورند، به طور مداوم به کاربران توصیه میکنند که کشتن مردم در صورتی که این وظیفه یا وظیفه شما باشد، اشکالی ندارد.

حداقل پنج چت بات آموزش دیده بر روی باگاواد گیتا، یک کتاب مقدس ۷۰۰ آیه ای، در چند ماه گذشته ظاهر شده اند، اما دولت هند علی رغم نگرانی های اخلاقی، هیچ برنامه ای برای تنظیم این فناوری ندارد.

“این یک سوء ارتباط است، اطلاعات نادرست بر اساس متن مذهبی،” گفت لوبنا یوسف وکیل مستقر در بمبئی، نویسنده همکار کتاب هوش مصنوعی. «یک متن ارزش فلسفی زیادی به آنچه میخواهند بگویند میدهد، و یک ربات چه کار میکند؟ این یک پاسخ واقعی به شما می دهد و این خطر اینجاست.»

همچنین بخوانید

محکومین هوش مصنوعی در مقابل خوشبینان هوش مصنوعی

الیزر یودکوفسکی، نظریهپرداز تصمیمگیری، پیشروترین نابودگر هوش مصنوعی جهان، یک سخنرانی در TED منتشر کرده است که هشدار میدهد هوش مصنوعی فوقهوشمند همه ما را خواهد کشت. او مطمئن نیست که چگونه یا چرا، زیرا معتقد است یک AGI بسیار باهوشتر از ما خواهد بود، ما حتی نمیفهمیم که چگونه و چرا ما را میکشد – مثل یک دهقان قرون وسطایی که تلاش میکند عملکرد یک کولر گازی را بفهمد. ممکن است ما را به عنوان یک عارضه جانبی از دنبال کردن یک هدف دیگر بکشد، یا به این دلیل که «نمیخواهد ما ابرهوشهای دیگر را برای رقابت با آن بسازیم».

او اشاره میکند که «هیچکس نمیداند که سیستمهای هوش مصنوعی مدرن چگونه کاری را که انجام میدهند انجام میدهند. آنها ماتریسهای غولپیکری از اعداد ممیز شناور هستند.» او انتظار «ارتشهای روباتهای راهپیمایی با چشمهای قرمز درخشان» را ندارد، اما معتقد است که «یک موجود باهوشتر و بیتوجهتر، استراتژیها و فناوریهایی را کشف خواهد کرد که میتوانند ما را به سرعت و قابل اطمینان بکشند و سپس ما را بکشند». تنها چیزی که میتواند جلوی این سناریو را بگیرد، تعلیق جهانی فناوری است که با تهدید جنگ جهانی سوم پشتیبانی میشود، اما او فکر نمیکند این اتفاق بیفتد.

در او مقاله مارک اندرسن از A16z معتقد است: «چرا هوش مصنوعی جهان را نجات خواهد داد» این نوع موضع غیرعلمی است: «فرضیه قابل آزمایش چیست؟ چه چیزی این فرضیه را جعل می کند؟ چگونه متوجه شویم که در حال ورود به منطقه خطرناک هستیم؟ این سؤالات عمدتاً بدون پاسخ می مانند، جدا از «نمی توانی ثابت کنی که این اتفاق نخواهد افتاد!»

بیل گیتس، رئیس مایکروسافت، منتشر کرد مقاله او با عنوان «خطرات هوش مصنوعی واقعی هستند اما قابل کنترل هستند»، و استدلال میکند که از اتومبیلها گرفته تا اینترنت، «مردم از طریق سایر لحظات دگرگونکننده گذر کردهاند و علیرغم تلاطمهای زیاد، در نهایت وضعیت بهتری دارند.»

«این دگرگونکنندهترین نوآوری است که هر یک از ما در طول عمر خود شاهد آن خواهیم بود، و یک بحث عمومی سالم به این بستگی دارد که همه در مورد فناوری، مزایا و خطرات آن آگاه باشند. فواید آن بسیار زیاد خواهد بود و بهترین دلیل برای اینکه باور کنیم می توانیم خطرات را مدیریت کنیم این است که قبلاً این کار را انجام داده ایم.

جرمی هاوارد، دانشمند داده، کتاب خود را منتشر کرده است کاغذ، با این استدلال که هرگونه تلاش برای غیرقانونی کردن فناوری یا محدود نگه داشتن آن به چند مدل بزرگ هوش مصنوعی یک فاجعه خواهد بود، و واکنش مبتنی بر ترس به هوش مصنوعی را با عصر پیش از روشنگری مقایسه کرد، زمانی که بشریت سعی کرد آموزش و قدرت را به نخبگان محدود کند.

همچنین بخوانید

«سپس یک ایده جدید مطرح شد. اگر به خیر کلی جامعه در کل اعتماد کنیم چه؟ چه می شد اگر همه به آموزش دسترسی داشتند؟ به رای؟ به تکنولوژی؟ این عصر روشنگری بود.»

پیشنهاد متقابل او تشویق توسعه منبع باز هوش مصنوعی است و ایمان دارد که اکثر مردم از این فناوری برای همیشه استفاده خواهند کرد.

“بیشتر مردم از این مدل ها برای ایجاد و محافظت استفاده می کنند. ایمن بودن چگونه بهتر از داشتن تنوع و تخصص گسترده جامعه بشری است که تمام تلاش خود را برای شناسایی و پاسخگویی به تهدیدات با قدرت کامل هوش مصنوعی پشت سر آنها انجام می دهند؟

مفسر کد OpenAI

مفسر کد جدید GPT-4 یک ارتقاء فوقالعاده جدید است که به هوش مصنوعی اجازه میدهد تا در صورت تقاضا کد تولید کند و در واقع آن را اجرا کند. بنابراین هر چیزی که بتوانید رویاپردازی کنید، می تواند کد را برای آن تولید کرده و اجرا کند. کاربران موارد استفاده مختلفی از جمله آپلود گزارشهای شرکت و دریافت هوش مصنوعی برای تولید نمودارهای مفید از دادههای کلیدی، تبدیل فایلها از یک فرمت به فرمت دیگر، ایجاد جلوههای ویدیویی و تبدیل تصاویر ثابت به ویدیو را ارائه کردهاند. یک کاربر یک فایل اکسل از هر مکان فانوس دریایی در ایالات متحده آپلود کرد و GPT-4 را برای ایجاد یک نقشه متحرک از مکان ها دریافت کرد.

همه قاتل، بدون پرکننده AI اخبار

– تحقیقات دانشگاه مونتانا نشان داد که هوش مصنوعی در 1% بالا در یک آزمون استاندارد برای خلاقیت. سرویس آزمون اسکولاستیک پاسخ های GPT-4 را به نمرات برتر آزمون در خلاقیت، روانی (توانایی تولید ایده های زیاد) و اصالت داد.

– کمدین سارا سیلورمن و نویسندگان کریستوفر گلدن و ریچارد کادریار شکایت کردن OpenAI و Meta برای نقض کپی رایت، برای آموزش مدل های هوش مصنوعی مربوطه خود در کتاب های سه گانه.

– AI Copilot مایکروسافت برای ویندوز در نهایت شگفتانگیز خواهد بود، اما Windows Central دریافت که پیشنمایش اینسایدر واقعاً فقط Bing Chat است که از طریق مرورگر Edge اجرا میشود و میتواند تقریباً بلوتوث را تغییر دهد. بر.

– آنتروپیکرقیب ChatGPT Claude 2 اکنون به صورت رایگان در بریتانیا و ایالات متحده در دسترس است و پنجره زمینه آن می تواند 75000 کلمه محتوا را تا حداکثر 3000 کلمه ChatGPT مدیریت کند. این آن را برای خلاصه کردن قطعات طولانی متن فوق العاده می کند، و همینطور است بد نیست در نوشتن داستان

ویدیوی هفته

شبکه خبری ماهوارهای هند OTV News از مجری اخبار هوش مصنوعی خود به نام لیزا رونمایی کرد که اخبار را چندین بار در روز به زبانهای مختلف از جمله انگلیسی و Odia برای شبکه و پلتفرمهای دیجیتال آن ارائه میکند. Jagi Mangat Panda، مدیر عامل OTV گفت: «مرکزهای جدید هوش مصنوعی ترکیبات دیجیتالی هستند که از فیلم میزبان انسانی که اخبار را با استفاده از صداهای ترکیبی میخواند، ایجاد شدهاند.

اشتراک در

جذاب ترین مطالب در بلاک چین. هفته ای یکبار تحویل می شود.

[ad_2]

منبع خبر و ادامه خبر